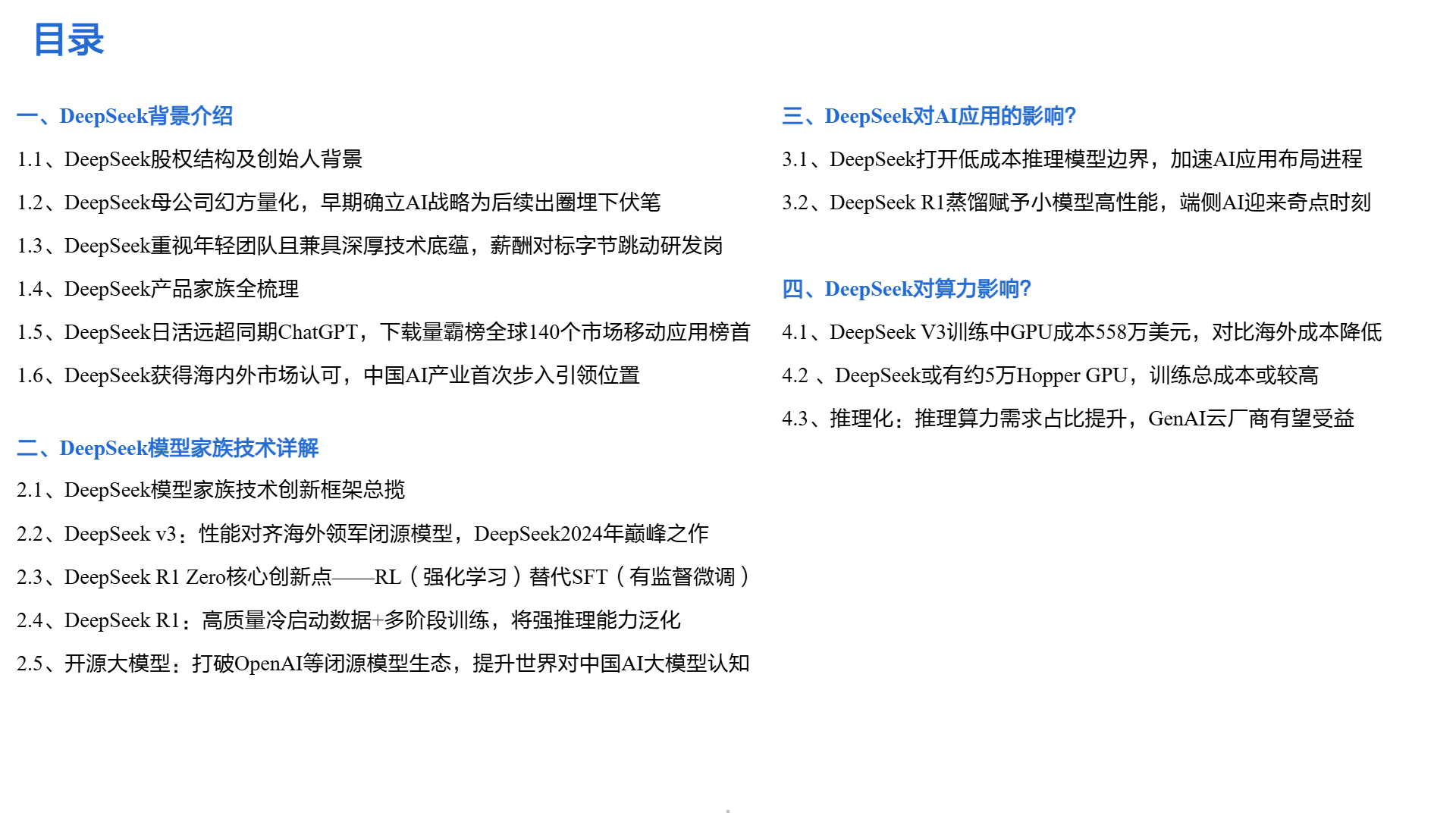

DeepSeek 作为 2023 年成立的中国初创企业,在 AI 领域成绩斐然。其创始人梁文锋来自幻方量化,在量化投资领域经验丰富,带领幻方量化在 2021 年资产管理规模突破千亿。DeepSeek 股权高度集中,梁文锋间接持股 83.29% ,直接持股 1%,累计 84.2945%。

DeepSeek 重视年轻团队,成员多为 Top 高校应届毕业生、实习生及毕业不久的年轻人,团队维持在约 150 人,推行扁平化管理。其薪酬对标字节跳动研发岗,吸引了大量人才。在产品方面,DeepSeek 产品家族丰富,涵盖多种类型模型。如 DeepSeek Coder、DeepSeek LLM 67B 等多个模型,且在性能上表现出色,DeepSeek-V3 在多项评测中超越 Qwen2.5 72B 和 Llama-3.1-405B 等开源模型,与 GPT-4o、Claude-3.5-Sonnet 性能相当 ;DeepSeek-R1 性能对标 OpenAI o1 正式版,在数学、代码、自然语言推理等任务上表现优异。同时,这些模型具有显著的性价比优势,DeepSeek V3 模型 API 服务定价为每百万输入 tokens 0.5 元(缓存命中)/2 元(缓存未命中),每百万输出 tokens 8 元;DeepSeek-R1 百万 tokens 输出价格约为 o1 的 1/27。

在市场表现上,DeepSeek 官方 App 上线后成绩惊人,上线 18 天日活达 1500 万,远超同期 ChatGPT(ChatGPT 达到相同日活耗费 244 天),上线 20 天日活突破 2000 万,发布前 18 天累计下载量 1600 万次,峰值日下载量 500 万次,几乎是 ChatGPT 同期的两倍,还在全球 140 个市场的移动应用下载量排行榜上位居榜首。DeepSeek 也获得了海内外市场的高度认可,英伟达、Meta、OpenAI、微软等科技巨头相关负责人均给予积极评价,微软、英伟达、亚马逊等一众科技巨头也纷纷拥抱 DeepSeek,上线其模型服务。

DeepSeek 在模型技术上创新不断。其 V3 模型采用了多项创新技术,MLA 机制显著节省计算资源及内存占用,通过低秩分解近似 Key 和 Value 的投影,减少键值缓存;DeepSeekMoE 架构及创新性负载均衡策略,在传统 MoE 架构基础上进行优化,提高计算效率;MTP 大幅提升模型性能,训练时可同时预测多个 token,推理速度提升 1.8 倍;采用 FP8 混合精度训练,计算速度相较于原始 BF16 方法提升一倍;DualPipe 算法减少流水线气泡,提升 GPU 利用率;定制的英伟达 PTX 指令实现细粒度控制与性能优化。DeepSeek R1 则以高质量冷启动数据和多阶段训练提升推理能力,R1 Zero 更是以 RL 替代 SFT,通过 GRPO 框架实现自我进化,在推理基准测试中性能卓越,如 AIME 2024 的 pass@1 分数从 15.6% 提升到 71.0%,多数投票下分数进一步提高到 86.7%,与 OpenAI-o1-0912 性能相当 。此外,DeepSeek 的开源大模型采用 MIT 协议,打破了 OpenAI 等闭源模型生态,提升了中国 AI 大模型的国际影响力,也为下游生态提供了优质的开源模型。

在 AI 应用方面,DeepSeek 影响深远。它打开了低成本推理模型边界,加速 AI 应用布局进程,其推理模型价格优势明显,推动了 AI 投资回报率的提升和应用商业模式的跑通。全球及中国 AI 应用市场规模加速增长,2024 年全球生成式 AI 市场规模达到 360.6 亿美元,同比增长 76%,预计 2028 年达到 2154 亿美元;中国 AI 软件市场规模在 2024 年为 5.7 亿美元,预计 2028 年达到 35.4 亿美元。同时,其强推理模型也在加速步入 AGI 之路。DeepSeek R1 蒸馏赋予小模型高性能,推动端侧 AI 发展,全球端侧 AI 市场规模预计从 2022 年的 152 亿美元增长到 2032 年的 1436 亿美元。

在算力方面,DeepSeek V3 训练中 GPU 成本为 557.6 万美元,对比海外模型成本显著降低。不过,DeepSeek 拥有大量 GPU 芯片,总服务器资本支出约为 13 亿美元,集群运营成本高达 7.15 亿美元,训练总成本较高。随着 AI 计算提效,推理算力需求占比提升,GenAI 云厂商有望受益。国产化方面,推理化趋势和中美博弈加剧,使得国产 AI 芯片需求有望提升,2024H1 中国 AI 芯片出货中,国产化比例达 20%,本土品牌加速卡持续优化硬件能力,市场份额有所增长,且软件调用能力提升,国产 AI 芯片生态蓬勃发展。此外,互联网厂商资本开支指引提升,ASIC 服务器采购占比增长,2024 年 ASIC 服务器占整体 AI 服务器的比重预计将升至 26%。同时,GB200 NVL 系列的发布,有望提升机柜、HBM、铜缆、液冷等市场的价值量占比。